Was Sie wissen müssen, bevor Sie mit A/B-Testing beginnen

Marketing-Teams, die eine echte Experimentierkultur etabliert haben, wissen: UX-Entscheidungen müssen auf verlässlichen Daten beruhen – nicht auf subjektiven Vermutungen. Nur so lässt sich eine hochwertige Online Experience bieten.

A/B-Testing unterstützt dich genau dabei, denn damit findest du heraus, was tatsächlich funktioniert, und kannst fundierte Entscheidungen für dein Unternehmen treffen.

Allerdings erfordert A/B-Testing eine klare, strukturierte Vorgehensweise, und es braucht etwas Zeit, bis man mit der Methode wirklich vertraut ist. Welche Voraussetzungen müssen erfüllt sein, um einen zuverlässigen A/B-Test durchzuführen? Und welche verschiedenen Arten von Tests stehen dir zur Verfügung?

In diesem Artikel beleuchten wir die Grundlagen und die wichtigsten Elemente, die du verstehen solltest, bevor du relevante Experimente umsetzt und eine erfolgreiche A/B-Teststrategie entwickelst.

Was ist A/B-Testing?

Ein A/B-Test ist ein Online-Experiment, das auf einer Website, in einer App oder einem anderen digitalen Kanal durchgeführt wird. Dabei wird eine mögliche Verbesserung eines Elements gegen eine Kontrollversion getestet. Anhand statistischer Analysen zeigt dir der Test anschließend, welche Version für deine Besucher:innen am effektivsten ist.

Die wichtigsten Vorteile von A/B-Testing

A/B-Testing gehört zu den stärksten Tools, die Marketing-Teams zur Verfügung stehen. Damit kannst du die gesamte User Experience auf deiner Website gezielt verbessern, die Beziehung zu deinen Besucher:innen stärken und sie zur Conversion führen.

Weitere Vorteile:

- Du verstehst deine Besucher:innen besser, weil du siehst, wie einzelne Elemente deiner Website ihr Verhalten beeinflussen.

- Du reduzierst subjektive Einschätzungen und triffst Entscheidungen auf Basis verlässlicher Daten, indem du deine Optimierungshypothesen sauber absicherst.

- Du fokussierst dich auf das, was – laut Testergebnissen – für die Mehrheit deiner Besucher:innen am besten funktioniert.

Wie A/B-Tests funktionieren

Schauen wir uns ein Beispiel an: Du fragst dich, wie sich die Anzeige der verbleibenden Artikelmenge auf das Verhalten der Besucher:innen deiner Produktseite auswirkt.

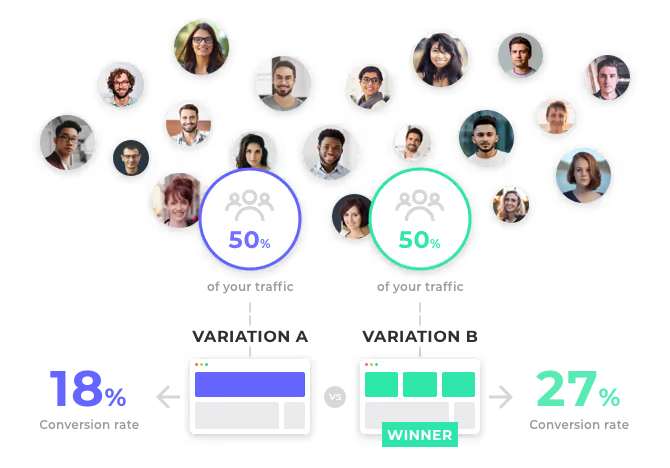

Um herauszufinden, welche Variante am besten funktioniert, erstellst du zwei Versionen der Seite und führst einen A/B-Test durch. Der gesamte Traffic wird dabei zufällig und gleichmäßig auf beide Varianten verteilt – natürlich völlig unbemerkt für die Besucher:innen.

Sobald der Test ein verlässliches Signifikanzniveau erreicht hat, kannst du die Ergebnisse auswerten und sehen, welche Version besser performt. Anschließend leitest du den gesamten Traffic auf die erfolgreichere Variante um – und schon kannst du mit dem nächsten Test weitermachen.

Identifziere, was auf deiner Website optimiert werden kann

Was kannst du testen?

Die Antwort ist simpel: so gut wie alles. Jedes Element deiner Website lässt sich prüfen – komplette Seiten, Formulare, Bilder, Texte, Call-to-Actions (CTAs), Links, Banner und vieles mehr.

Du kannst alle Optimierungsansätze testen, die die User Experience verbessern könnten, zum Beispiel:

- Position, Größe und Design deiner CTAs

- Anzahl und ideale Abfolge der Schritte im Conversion Funnel

- Format und Umfang von Mitteilungen oder Hinweisen

- … und vieles mehr

Was sind die Voraussetzungen für die Durchführung einer A/B-Teststrategie?

Deine A/B-Tests sollten einer klaren, strukturierten Vorgehensweise folgen – nur so kannst du Ideen sinnvoll priorisieren und statistisch belastbare Ergebnisse erzielen.

Eine Testing-Roadmap erstellen

Es ist wichtig, deine Tests gut zu planen, um deiner Optimierungsstrategie eine klare Struktur zu geben. Eine sinnvolle Priorisierung hilft dir dabei, das Beste aus deiner Website herauszuholen und deine Ressourcen effizient einzusetzen.

Damit deine Roadmap wirklich zu deinen Business-Zielen passt, solltest du:

- das Ziel deiner Tests festlegen: Möchtest du Conversion, Engagement oder Kundenbindung steigern? Klare Ziele sind entscheidend, um Ergebnisse später korrekt bewerten zu können.

- die passenden KPIs definieren: etwa durchschnittliche Besuchsdauer, Klickrate oder Anzahl der Seitenaufrufe. Die KPIs sollten immer direkt auf deine Testziele abgestimmt sein.

- deine Tests priorisieren: Bewerte jedes potenzielle Experiment nach Kriterien wie Potenzial, Relevanz und Umsetzbarkeit, um eine sinnvolle Reihenfolge festzulegen.

- die Ergebnisse kommunizieren: Sowohl vor als auch nach einem Test ist der Austausch mit deinem Team und anderen Stakeholdern wichtig, um eine kontinuierliche Weiterentwicklung zu unterstützen.

Starkes Traffic-Volumen zuweisen

Ein entscheidender Faktor für verlässliche Testergebnisse ist die Menge der verfügbaren Daten. Konkrete Zahlen lassen sich zwar nicht pauschal festlegen, aber folgende Faustregeln helfen dir bei der Orientierung:

- Unter 10.000 monatlichen Besuchern:

A/B-Tests funktionieren vor allem bei sehr klar abgegrenzten Elementen wie CTAs oder Formularen – und auf deinen am stärksten besuchten Landing Pages. - 10.000 bis 200.000 monatliche Besucher:

Du kannst bereits mehr A/B-Tests durchführen, musst aber damit rechnen, dass sie etwas länger laufen, bevor aussagekräftige Ergebnisse vorliegen. - 200.000 bis 1 Mio. monatliche Besucher:

Dein Traffic ist ausreichend hoch für umfangreiches A/B-Testing. Schwieriger wird es nur bei Seiten mit weniger Besuchern, wie etwa den letzten Schritten im Conversion Funnel. - Über 1 Mio. monatliche Besucher:

Ab diesem Level ist Traffic in der Regel kein limitierender Faktor mehr.

Welche unterschiedlichen Arten von A/B-Tests können Sie durchführen?

Es gibt verschiedene Arten von A/B-Tests – je nachdem, welche Ziele du verfolgst und welche Bedürfnisse dein Projekt hat. Hier findest du eine Einführung in die wichtigsten Methoden, die du dafür nutzen kannst.

Multivariate Testing

Manchmal lohnt es sich, mehrere Änderungen an einem Element gleichzeitig zu testen – etwa das Wording und die Farbe eines CTAs oder das Zusammenspiel aus Bild und Text in einem Banner. Ein Multivariate Test ermöglicht dir genau das: Du kannst all diese Varianten in einem einzigen Experiment gegeneinander antreten lassen und erkennen, welche Kombination am besten performt.

Wann sollten Sie einen Multivariate Test (MVT) durchführen?

Allerdings benötigt ein Multivariate Test sehr hohen Traffic, damit die Ergebnisse wirklich statistisch aussagekräftig sind. Denn es entstehen so viele Varianten, wie Kombinationen der getesteten Elemente möglich sind.

Wenn du tiefer einsteigen möchtest: Wir haben einen ausführlichen Artikel zum Thema Multivariate Testing für dich vorbereitet.

A/B/n-Testing

Ein A/B/n-Test ermöglicht es dir, mehrere Optimierungshypothesen für eine Seite gleichzeitig zu prüfen. Du kannst zum Beispiel sechs Varianten einer Seite gegeneinander testen – also einen A/B/C/D/E/F-Test durchführen.

Wann sollten Sie A/B/n-Tests durchführen?

Ein A/B/n-Test eignet sich besonders dann, wenn du mehrere Versionen einer Seite testen möchtest, die sich deutlich voneinander unterscheiden – etwa im Layout, im Design oder in der inhaltlichen Struktur.

Der Unterschied zum Multivariate Test (MVT) liegt dabei klar auf der Hand:

Ein MVT erzeugt verschiedene Varianten aus allen möglichen Kombinationen einzelner Elemente, die du verändern möchtest.

Wenn du jedoch das gesamte Seitenlayout überarbeiten oder umfangreiche Designänderungen testen willst, ist ein A/B/n-Test die deutlich bessere Wahl.

Dynamic Traffic Allocation Tests (oder auch Multi-Armed Bandit Algorithmen)

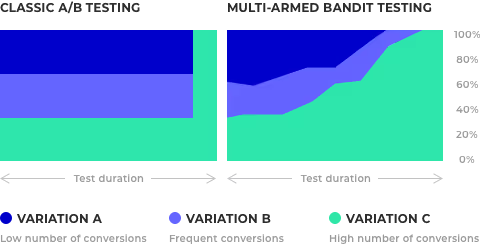

Bei der dynamischen Traffic-Aufteilung sorgt ein Algorithmus dafür, dass deine Besucher:innen automatisch – und schrittweise – auf die Variante geleitet werden, die sich als erfolgreicher herausstellt.

Bei einem Standard-A/B-Test wird der Traffic bis zum Ende des Experiments gleichmäßig verteilt. Testest du zum Beispiel zwei CTA-Varianten, erhält Variante A 50 % des Traffics und Variante B die anderen 50 %.

Bei der dynamischen Traffic-Aufteilung dagegen passt sich die Verteilung laufend an die Performance der Varianten an. Liefert Variante B also eine deutlich höhere Conversion Rate, wird automatisch mehr Traffic auf diese Version umgelenkt.

Mehr Details findest du in unserem Artikel über dynamische Traffic-Aufteilung.

Wann sollten Sie die dynamische Traffic-Aufteilung nutzen?

Die dynamische Traffic-Aufteilung ist in zwei Fällen besonders sinnvoll:

- Bei Tests über einen begrenzten Zeitraum:

Du leitest schneller einen größeren Teil deines Traffics auf die Gewinnvariante und holst damit das maximale Conversion-Potenzial heraus. - Bei Tests, deren Ergebnisse du nicht laufend verfolgen kannst:

Der Algorithmus übernimmt die Arbeit für dich. Du konfigurierst den Test einmal und lässt ihn dann laufen. Die Lernphase dauert zwar länger, aber der Traffic wird kontinuierlich zur besten Variante gelenkt.

Damit die dynamische Traffic-Aufteilung aussagekräftige Ergebnisse liefert, brauchst du jedoch ein hohes Besuchervolumen. Sie sollte daher gezielt und zu strategisch wichtigen Zeitpunkten eingesetzt werden – und Marketer müssen diesen Kontext bei der Ergebnisanalyse immer berücksichtigen.

Wie bereits in diesem Artikel beschrieben: A/B-Testing ist nichts, was man improvisieren kann.

Für verlässliche Ergebnisse musst du deine Tests priorisieren, ihnen ausreichend Traffic zuweisen und die Methode wählen, die am besten zu deinen Zielen passt.

Wenn du diese Schritte konsequent befolgst, kannst du fundierte Entscheidungen treffen – und sowohl die Conversion als auch das Engagement deiner Besucher:innen nachhaltig optimieren.

“We needed a way to assess visitor interest more accurately. With manual scoring, lead quality was too low. We chose Kameleoon for its AI, which precisely targets visitors based on their interest in our cars.”

“This campaign shows the multiple benefits of artificial intelligence for personalization. Toyota’s teams have been completely convinced by the performance of Kameleoon’s AI personalization solution and are expanding this approach across the customer journey.”