Quand arrêter un test A/B ?

Arrêter un test A/B trop tôt est sans doute l’une des erreurs les plus courantes et les plus préjudiciables. En stoppant un processus d’expérimentation prématurément, vous prenez le risque de ne pas obtenir de résultat probant. Pire, vous pourriez tirer des conclusions erronées de vos tests, et faire des choix qui détériorent vos taux de conversion.

Quels sont les éléments à prendre en compte pour arrêter vos tests A/B au bon moment ? Dans cet article, nous revenons sur les quatre paramètres à observer pour définir la durée optimale pour vos tests :

- l’indice de confiance

- la taille de l’échantillon

- la durée de votre test

- la variance des données

Note : il ne suffit pas de se fier à l’un de ces indicateurs, vous devez tous les prendre en compte pour identifier le meilleur moment pour arrêter votre test.

1. L’indice de confiance

Il ne faut pas se fier à un test qui indique un indice de confiance inférieur à 95%. L’indice de confiance est un pourcentage qui vous indique les chances d’obtenir de meilleurs résultats avec la variante testée. À 95%, il y a donc 5% de chance (soit 1 chance sur 20) pour que le résultat final ne corresponde pas au résultat obtenu lors du test. Si vous stoppez un test avec un indice de 80%, vous passez de 1 chance sur 20 d’obtenir un résultat aléatoire à 1 chance sur 5 ! Attention, la confiance statistique est nécessaire, mais non suffisante à l’arrêt d’un test. En réalisant un test de deux variantes identiques (un test A/A), vous avez plus de 7 chances sur 10 d’obtenir un indice de confiance de 95% à un moment donné. Seul, l’indice de confiance n’est donc ni suffisant, ni pertinent et il faut prendre en compte d’autres éléments pour s’assurer de la validité d’un A/B test.

2. La taille de l'échantillon

Lorsque l’on parle de la taille de l’échantillon, on désigne le nombre de personnes qui doivent être exposées au test pour obtenir des résultats valables.

Un échantillon représentatif de votre audience

Votre échantillon doit être représentatif de votre audience (sauf si vous souhaitez A/B tester un segment spécifique). En effet, au début d’un test, l’échantillon n’aura pas encore pris en compte tous les types de visiteurs qui se rendent sur votre site et vos résultats peuvent être faussés puisque les visiteurs exposés au test ne seront pas nécessairement les mêmes que ceux qui verront votre optimisation ensuite. La connaissance de son audience est essentielle et vous devez analyser votre trafic avant de lancer un test A/B. Voici un exemple de quelques éléments que vous devez connaître :

- Combien de mes visiteurs proviennent de PPC (SEA), trafic direct, de recherches organiques, d’emails, de parrainages, etc. Le taux de nouveaux visiteurs vs. Visiteurs existants

- Aussi, une variation pourrait rencontrer un grand succès dès la première journée mais être finalement la variante la moins efficace à mesure que l’échantillon grandit.

En arrêtant le test après une journée, vous auriez des résultats tronqués et non-applicables à la plus grande part de votre audience.

Un échantillon suffisamment important

L’échantillon doit également être suffisamment important pour subir la variation naturelle des données. Plus l’échantillon est petit, plus les écarts sont importants d’une version à l’autre. Qu’est-ce que cela veut dire ? Voici un exemple concret. On lance une pièce 10 fois. La probabilité « réelle » de notre pièce est de 50 %. On répète l’expérience 5 fois et on calcule le % d’apparition du pile (P = pile ; F = face).

Le résultat varie de 30 à 80 %. On reproduit la même expérience en lançant cette fois-ci la pièce 100 fois au lieu de 10 (grâce à un simulateur). Le résultat varie de 47 à 54 %. En somme, plus l’échantillon est large, plus le résultat obtenu est proche de la « vraie » valeur (ici comprise entre 47 % et 54 %, à savoir 50 %).

Quelle taille pour mon échantillon ?

Une chose s’applique à toutes les méthodes statistiques : plus on collecte de données, plus les résultats sont fiables. Toutefois, le résultat varie en fonction de la méthode appliquée par vos outils (bayésienne ou fréquientiste). Je vais vous donner les conseils que l’on donne à nos clients pour utiliser notre outil (selon la méthode fréquentiste). Pour déterminer de la taille d’échantillon, nous recommandons à nos clients d’utiliser un calculateur comme celui-ci. Il donne une bonne estimation de la taille d’échantillon requise. Le calculateur vous permet également de ne pas arrêter vos tests prématurément puisque vous connaissez la taille d’échantillon requise au préalable (vous ne devriez pas vérifier les performances de vos variations avant d’atteindre ces chiffres).

3. La durée du test

Nous recommandons de lancer des tests de plusieurs semaines (au moins 2 à 3 semaines). Si vous le pouvez, l’idéal est de lancer un test correspondant à votre cycle de vente (voire deux). Vous savez probablement qu’il existe un moment optimum pour envoyer un mail ou poster sur les réseaux sociaux. En effet, les gens se comportent différemment selon le moment de la journée et sont influencés par de nombreux facteurs externes (météo, actualité, soldes, etc.). Les taux de conversion sont par conséquent impactés. Pour vous en rendre compte, analysez votre taux de conversion au cours de la journée, et notez les variations d’un jour à l’autre. En lançant votre test en fonction de votre cycle de vente, vous capturerez les données de nouveaux visiteurs et celles de visiteurs sur le point de convertir (créant ainsi un test tenant compte de nombreux facteurs externes et sources de trafic). Par ailleurs, il est important de mener des tests sur des cycles entiers pour limiter l’effet trompeur des facteurs externes. Ainsi, si vous commencez un jeudi, terminez un jeudi (prévoyez au moins 2 à 3 semaines de test). Dans le cas où vous devez étendre la durée de votre test, faites le d’une semaine (et non pas seulement de quelques jours) pour respecter la durée du cycle.

4. La variance des données

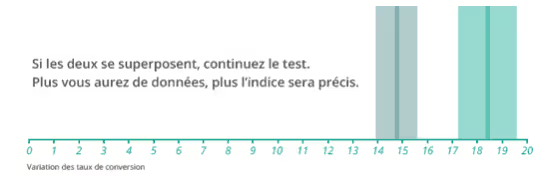

Si votre indice de confiance et vos taux de conversion fluctuent encore beaucoup, n’arrêtez pas votre test, vos données doivent être stabilisées. Deux phénomènes sont à considérer : L’effet de nouveauté : c’est lorsque les visiteurs réagissent à votre changement, simplement parce qu’il est nouveau. Il s’estompe avec le temps. Régression à la moyenne : plus vous récoltez de données, plus vous approchez de la valeur « réelle » des résultats de votre test. C’est pour cette raison que vous obtenez des résultats variables au début d’un test. C’est pour cela que l’indice de confiance de 95% n’est pas forcément suffisant pour mettre fin à un test. Assurez vous que votre indice de confiance et vos taux de conversion se stabilisent avant de vous arrêter, les fluctuations doivent être négligeables. Imaginez deux versions :

- une version A avec un taux de conversion de 18,4% ± 1,2%

- une version B au taux de conversion 14,7% ± 0,8%.

Cela signifie que le taux de conversion de la version A se trouve entre (18,4 – 1,2 soit 17,2) et (18,4 + 1,2 soit 19,6), et que celui de la version B se trouve entre (14,7 – 0,8 soit 13,9) et (14,7 + 0,8 soit 15,5).

En somme, la meilleure façon de ne pas céder à la tentation et mettre fin à un test parce qu’une variable « semble » se démarquer est de ne pas vérifier les résultats trop tôt.

5. Pour résumer

Avant de mettre fin à un test, il faut réunir les conditions suivantes :

- Un indice de confiance de 95%

- Un échantillon représentatif de votre audience.

- Un test suffisamment long

- Des taux de conversion et de confiance stables.

N’arrêtez un test qu’une fois que vous avez pris ces éléments en compte. Sinon, vous perdrez du temps et de l’argent.

“We needed a way to assess visitor interest more accurately. With manual scoring, lead quality was too low. We chose Kameleoon for its AI, which precisely targets visitors based on their interest in our cars.”

“This campaign shows the multiple benefits of artificial intelligence for personalization. Toyota’s teams have been completely convinced by the performance of Kameleoon’s AI personalization solution and are expanding this approach across the customer journey.”