Erreurs de type I et II en A/B Testing : les comprendre et les éviter

Les erreurs de type I et II surviennent lorsque vous tirez des conclusions erronées à partir des résultats d’un test A/B ou d’un ensemble de données. Elles correspondent à deux situations opposées :

- L’erreur de type I se produit lorsque vous rejetez à tort l’hypothèse nulle. Vous croyez à un effet qui n’existe pas. → Faux positif

- L’erreur de type II à l’inverse, survient lorsque vous acceptez à tord l’hypothèse nulle. Vous passez à côté d’un effet réel. → Faux négatif

L’hypothèse nulle, base de tout test

Dans le cadre du A/B Testing, l’hypothèse nulle (H₀) stipule qu’il n’existe aucune différence significative entre deux versions testées. Autrement dit, elle suppose que le changement que vous testez n’a aucun impact sur votre métrique cible (conversion, clics, revenus…).

Dans cet article, nous allons explorer :

- Qu’est-ce qu’une erreur de type I ?

- Qu’est-ce qu’une erreur de type II ?

- Quelle est la différence entre les erreurs de type I et les erreurs de type II ?

- Comment limiter leur apparition

- Les bonnes pratiques à retenir

Qu’est-ce qu’une erreur de type I ?

L’erreur de type I se produit lorsque vous concluez, à tort, que votre variation a eu un impact significatif. Autrement dit, vous détectez un effet inexistant et rejetez injustement l’hypothèse nulle.

Le rôle du seuil de significativité (alpha)

La probabilité de faire une erreur de type I dépend du seuil de significativité (α) que vous avez fixé. En A/B Testing, il est généralement fixé à 5 % (α = 0,05). Cela signifie que vous acceptez un risque de 5 % d’observer un résultat statistiquement significatif alors qu’il ne l’est pas réellement.

Comprendre la mécanique : p-value vs. alpha

Lorsque vous configurez votre test, vous définissez ce seuil α. Ensuite, votre solution d’expérimentation compare la p-value de votre test à ce seuil :

- Si p < α : les résultats sont considérés comme significatifs, vous pouvez rejeter l’hypothèse nulle.

- Si p ≥ α : aucun effet n’est détecté, vous ne rejetez pas l’hypothèse nulle.

Attention : si vous consultez les résultats trop tôt, la p-value peut temporairement chuter sous le seuil, sans que l’effet soit réel. Elle n’est fiable qu’à la fin du test.

Exemple concret : Une erreur de type I

Vous testez un nouveau message dans le header de votre page d’accueil pendant 7 jours. Vous fixez un seuil de significativité à 95 % et lancez le test un lundi matin. Dès le mercredi, vous jetez un œil aux résultats : le challenger semble gagner. Vous stoppez le test et déployez la variation. Après déploiement, aucun changement notable. Résultat : vous avez tiré une conclusion hâtive… et commis une erreur de type I.

Ce type d’erreur est courant lorsqu’on pratique le “peeking” (regarder les résultats avant la fin du test). Si vous avez besoin de flexibilité, pensez aux tests séquentiels, qui permettent une analyse continue sans fausser les résultats.

Qu’est-ce qu’une erreur de type II ?

À l’inverse, l’erreur de type II survient lorsque vous concluez à tort que votre variation n’a eu aucun effet. Vous ne rejetez pas l’hypothèse nulle alors que celle-ci est fausse : vous manquez une opportunité réelle.

Le rôle de la puissance statistique (1 - β)

Votre risque de commettre une erreur de type II dépend de la puissance statistique du test (souvent notée 1 - β). Généralement fixée à 80 %, cela signifie que :

- Vous avez 80 % de chances de détecter un effet existant.

- Mais vous conservez 20 % de risque de passer à côté d’un effet réel (erreur de type II).

Comment éviter ce type d’erreur ?

Faites systématiquement une analyse de puissance avant de démarrer vos tests. Cette analyse vous permet de définir :

- la taille d’échantillon nécessaire,

- le niveau de significativité (α),

- la taille d’effet minimale que vous espérez détecter.

Vous pouvez calculer ces paramètres facilement à l’aide d’un calculateur pour AB tests. Utilisez ensuite ces paramètres dans votre solution d’expérimentation pour garantir une exposition adéquate.

Exemple concret : une erreur de type II

Reprenons notre test d’A/B sur le message dans le header. Cette fois, il aurait fallu exposer chaque version à 10 000 utilisateurs. Vous n’avez pas atteint ce seuil mais en voyant l’absence de résultats significatifs au bout de 7 jours, vous avez arrêté le test. Plus tard, un client vous dit que le nouveau message a motivé sa conversion. Vous relancez donc le test, cette fois avec une taille d’échantillon suffisante, et la variation l’emporte nettement. En arrêtant prématurément le premier test, vous aviez commis une erreur de type II.

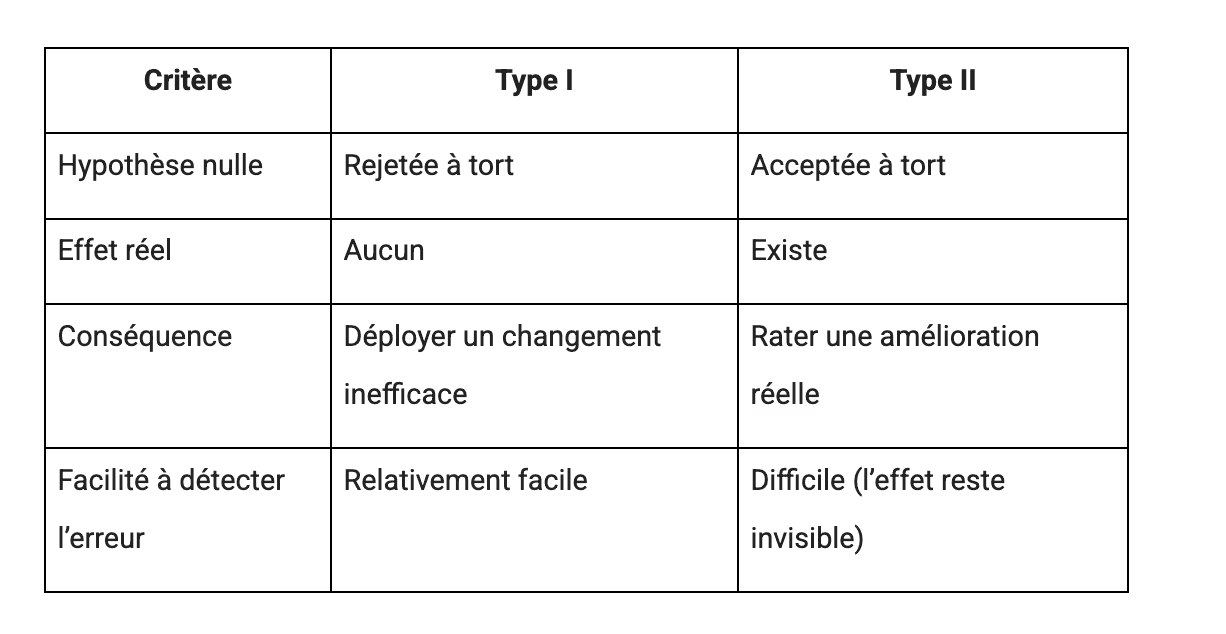

Quelle est la différence entre erreurs de type I et de type II ?

Les deux erreurs sont coûteuses :

- Type I : Vous prenez de mauvaises décisions basées sur un faux effet.

- Type II : Vous ratez une réelle opportunité d’amélioration.

Comment limiter les erreurs de type I et II ?

Vous ne pourrez jamais totalement éliminer ces erreurs, mais vous pouvez largement réduire leur fréquence et leur impact. Attention ! Réduire une erreur augmente le risque de commettre l’autre :

- Si vous réduisez α (par exemple à 1 %), vous diminuez les erreurs de type I, mais vous risquez davantage l’erreur de type II.

- Si vous augmentez fortement la puissance statistique, vous risquez de générer plus d’erreurs de type I.

6 conseils pratiques pour éviter ces erreurs :

- Respectez les standards. Seuils de 5 % pour la significativité et 80 % pour la puissance.

- Faites une analyse de puissance avant le test. Calculez la bonne taille d’échantillon à l’avance. Ne lancez jamais un test “à l’aveugle”.

- Laissez le test tourner jusqu’à la fin prévue. Pas de peeking !

- Investissez dans une solution d’expérimentation fiable, avec un moteur statistique robuste.

- Pratiquez des tests A/A pour détecter des biais techniques.

- Documentez clairement vos hypothèses et critères de succès.

Pour conclure

Les erreurs de type I et II font partie intégrante de l’A/B Testing, mais vous pouvez les contrôler et réduire fortement leur fréquence en adoptant une méthodologie rigoureuse. Mieux vaut anticiper ces erreurs que de les subir ! Gardez un esprit critique : tout effet apparent n’est pas forcément réel.

Pour aller plus loin, regardez notre webinar de 30 minutes dédié à ce sujet.

“We needed a way to assess visitor interest more accurately. With manual scoring, lead quality was too low. We chose Kameleoon for its AI, which precisely targets visitors based on their interest in our cars.”

“This campaign shows the multiple benefits of artificial intelligence for personalization. Toyota’s teams have been completely convinced by the performance of Kameleoon’s AI personalization solution and are expanding this approach across the customer journey.”